Research Progress and Application Prospect of Large Language Model in the Traditional Chinese Medicine

-

摘要:

采用人工智能技术研发的中医药领域大语言模型,推动了中医药的创新与发展,对中医药的传承和创新具有重要意义。基于大语言模型的研究背景,阐述了中医药领域大语言模型的研究现状和研究过程,包括收集中医药领域数据信息、输入指令数据微调模型及选择不同评估方法评测模型性能三个关键任务。总结了中医药大语言模型的前沿技术,如提示工程、检索增强生成、人类反馈强化学习等理论应用,有效提升了大语言模型在中医药领域各种应用场景中的适应能力。分析了中医药大语言模型仍面临的困难及挑战,在数据隐私、伦理偏见、模型解释、技术难题、评估标准等方面仍需进一步优化提升。展望了未来中医药大语言模型的应用前景,将其与深度学习等先进人工智能技术相结合,并融合中医四诊信息、中药图像数据等多模态信息,可为大语言模型在中医药领域的发展提供新的思路,从而更好地服务中医辨证诊断、中药处方推荐、中医药知识图谱构建、中医药教育等各种应用场景。

Abstract:The development of large language models in the field of Traditional Chinese Medicine (TCM) using artificial intelligence has significantly contributed to both the innovation and preservation of TCM. This paper outlines the current research status and process of large language models in TCM, focusing on three key tasks: collecting TCM data, fine-tuning models with specific instructions, and using different methods to evaluate model performance. It also highlights cutting-edge techniques, such as prompt engineering, retrieval-augmented generation, and reinforcement learning from human feedback, which have enhanced the models' adaptability in various TCM applications. The challenges faced by TCM language models, such as data privacy, ethical biases, model interpretability, technical difficulties, and evaluation standards, are also analyzed, indicating areas for further improvement. Looking ahead, the combination of these models with advanced AI techniques like deep learning, and the integration of multimodal information such as TCM diagnostic data and herbal images, can open new possibilities for large language models in TCM. This will enhance their application in areas like syndrome differentiation diagnosis, prescription recommendations, TCM knowledge graph construction, and TCM education.

-

中医药知识灿若星辰、世代传承,是中华民族千年健康智慧的结晶。近年来,随着《“十四五”中医药发展规划》的实施,中医药的数字化和信息化得到了显著推进。在大数据和人工智能的助力下,中医药领域的研究取得了重大进展。机器学习和深度学习技术的应用,显著提高了中医四诊的诊断准确性[1]、中药处方的推荐效率[2]以及中医知识图谱的构建质量[3]。传统医学诊断的智能诊疗模型常被应用于病证预测、证候分型等研究中,在有限集合中有效实现了中医临床决策和方药推荐。尽管如此,中医数据的复杂性和庞杂性,及临床上患者病情和处方用药的多样性和灵活性,需要智能诊疗模型具备更高的适应性和准确性[4-5]。

大语言模型技术的发展使个性化医疗和健康管理成为可能,利用其文本生成能力不仅能避免传统智能诊疗模型的局限性,还能在医学研究、医疗诊断、医学考试等应用中具备强大的适应性。最近,大语言模型在中医药领域的研究已有成效,为中医药的自然语言处理研究提供了新的视角和方法。中国工程院院士、国医大师张伯礼在接受专访时表明,以“数智本草”“天河灵枢”为代表的大模型已为中医药产业的创新和发展提供了新的动力[6]。由此,大语言模型成为推动中医药现代化发展的重要力量,基于微调技术训练模型,能够有效提高其在不同任务场景中的生成创造能力,有助于为医生和患者提供更为高效的中医诊疗服务。为了更全面地了解中医药领域大语言模型的研究进展与应用前景,本文通过对相关文献进行综述,旨在为未来中医药领域大语言模型的应用研究提供理论和实践的参考,这不仅将推动中医药的现代化进程,也将有助于其在全球健康治理中发挥更大的作用。

1. 大语言模型在中医药领域的研究进展

1.1 大语言模型的研究背景

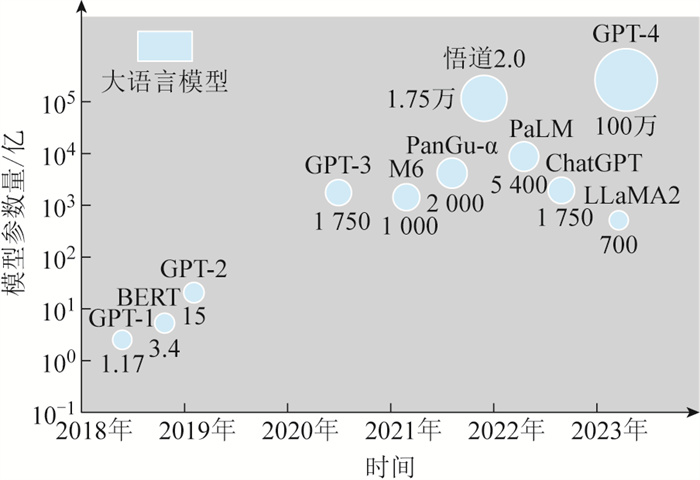

语言模型的发展最早追溯到基于马尔可夫假设的n-gram模型,后来至21世纪初,统计机器翻译成为当时的主流技术。随着深度学习的出现,以word2vec[7]为代表的神经网络模型实现了文本语义的分布式单词表示,不仅更好地避免了文本系数问题,且更易捕捉到建模长距离依赖关系。2017年,Vaswani等[8]提出了基于自注意力机制的Transformer神经网络架构,可有效捕捉长距离依赖关系。2018年,BERT[9]和GPT[10]模型相继问世,随后基于Transformer的预训练模型在序列生成和结构映射任务中表现突出。如图 1所示,自BERT和GPT模型出现之后,语言模型的参数规模实现快速扩大,当其参数量和训练数据量达到一定规模时便质变成大语言模型。基于自注意力机制的大语言模型性能仍在不断改进提升,这将促进医学决策的智能化发展。

1.2 中医药领域大语言模型的研究现状

现阶段,大语言模型在中医学领域的研究和应用正蓬勃发展,可提供智能问答、辅助诊疗、病历生成等多种场景化服务,使得中医药的研究、临床应用及发展得到了强大技术支持。大语言模型在中医药领域的研究成果及其独特优势如表 1所示[11-19]。

表 1 中医药领域的大语言模型Table 1. Large language model in the field of traditional Chinese medicine模型名称 发布时间 基座模型 指令数据 学习范式 独特优势 应用场景 获取途径 TCM-GPT-7B[11] 2023 BLOOM-7B 主要有来源于百度百科和维基百科的20GB的一般语料数据、共6 325个选择题的中医特定检查数据集(TCM-EXAM)和共7 783份中医电子健康记录的数据集(TCM-EHR) 预训练、指令微调 首次在中医药领域对具有7亿参数的大语言模型进行领域适应性验证,并利用基于图的排序算法TextRank和开源的中医词典构建了大规模中医特定语料库TCM-Corpus-1B,显著提升了模型在中医考试和诊断任务中的性能 中医考试和中医诊断 / HuatuoGPT-Ⅱ[12] 2023 Baichuan2 使用了1.1TB的中英文数据,转换成问题-答案对的格式,共2.6万亿个标记 预训练指令微调 将预训练和监督微调统一为一个阶段,并通过数据统一方法将异构数据转换为统一格式,极大增强了模型利用领域知识的能力,使之在中医专业的基准测试中相较于ChatGPT和GPT-4具有独特优势 中医专业测试 https://github.com/Freedom-Intelligence/HuatuoGPT-II ZhongJing中医大模型[13] 2023 LLaMA 包含约70 000个多轮对话和400 000个会话的中国医学多轮问答数据集 预训练、指令微调、人类反馈强化学习 引入了近端策略优化算法引导模型实现与专家医生的意图对齐,显著提升了模型处理复杂对话和主动询问的能力 中医医疗问答 https://github.com/SupritYoung/Zhongjing EpidemicCHAT[14] 2023 ChatGLM 6.9百万条指令数据,包括从194本中医古籍中收集与疫病相关的内容,及中医疫病防治知识图谱 指令微调 扩大了中医药领域大语言模型覆盖的疾病范围,显著提升了模型生成中医疫病防治处方的性能 中医疫病预防和治疗领域的智能问答、症状辅助诊断和中药处方生成 / Lingdan[15] 2024 Baichuan2-13B-Base 共有3个数据集,分别是中医预训练数据集(TCMPT)、中成药问答数据集(TCPM QA)和脾胃草药处方推荐数据集(SSHPR),来源于中医古籍、教材和临床数据等 预训练、指令微调 显著提高了模型在中医临床知识问答和草药处方推荐任务中的性能 中医临床诊断、中药处方推荐 https://github.com/TCMAI-BJTU/LingdanLLM Huang-Di大模型[16] 2024 Ziya-LLaMA-13B-V1 504 372条包含单轮对话和多轮对话的中医古籍指令对话数据及约52k的中文Alpca-GPT-4通用指令微调数据 预训练、指令微调、DPO优化 首个针对中医古籍领域的大语言模型,且结合了自动评估和人工评估两种方法进行模型评估,有效地突破了中医古籍数字化的传统研究模式 中医古籍知识问答 https://github.com/Zlasejd/HuangDI Qibo[17] 2024 LLaMA 主要分为四类指令数据集,包括中医单轮对话数据、中医多轮对话数据、中医自然语言处理任务指令数据和通用医疗相关对话数据 预训练、指令微调 在结合中医知识图谱的同时,通过采用不同粒度的数据处理规则,提升了训练语料的质量,有效增强了模型在中医知识问答方面的泛化性 中医领域知识问答 / CPMI-ChatGLM[18] 2024 ChatGLM-6B 3 906条精心标注的中国专利药物记录 指令微调 首次利用大语言模型对中医专利药物记录进行综合研究,并分别利用LoRA和P-Tuning v2方法进行模型的微调训练 中医药物推荐和用药建议 https://github.com/liucaNN/CPMI-ChatGLM 数智本草 2024 / 1 000种以上古籍及翻译、9万首以上方剂、4 000万份以上文献摘要、2万个以上靶基因通路信息、10万个以上临床方案、16万个以上中药专利及药典政策指南等 预训练、指令微调 “数智本草”语言大模型拥有380亿参数量,有助于帮助学者完成中医药理论证据的挖掘和总结。“数智本草”计算大模型能够更精准地执行计算任务,并结合相应算法快捷实现药材与复方的筛选和优化。 中医智能问答、模型交互计算、中医报告生成 / 天河灵枢[19] 2024 天河天元大模型 中医经典名著、针灸临床循证证据库、中医循证知识图谱等 预训练、指令微调 首个面向中医针灸领域的大语言模型,可提供包括针刺、艾灸、按压等多种针灸治疗方法的个性化建议 中医针灸诊疗问答 / 1.3 中医药领域大语言模型的研究过程

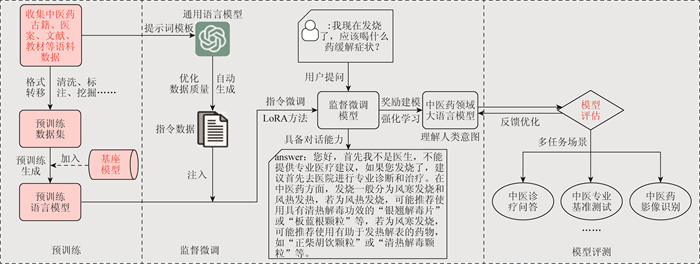

为使大语言模型适应中医药领域各种应用场景,提高模型泛化能力,多数学者基于微调技术训练模型, 在已构建好的语言模型(可称为“基座模型”)基础之上,通过标注语料数据进一步训练优化模型,使模型能够更好地学习并理解中医药学“辨证论治”的方法特点。基于微调的中医药领域大语言模型研究过程如图 2所示。

1.3.1 预训练

在微调模型前期,需先通过预训练使基座模型初次掌握中医药领域知识,通常是以无监督学习的方式,从收集的古籍文献、医案病历、教材典籍等文本数据中自主接触和获取知识及特征,提升模型领域通用语言表示能力。在预训练阶段,应根据推理速度选择效率最高的基座模型,通常选择6B到13B的模型监督微调医学领域语言模型[20]。

1.3.2 监督微调

当已构建好预训练语言模型之后,便进入监督微调阶段,此阶段是在有监督条件下触发模型的对话能力,方便用户向模型问询疾病、症状、药物服用等中医诊断相关问题,从而提升模型以任务为导向的性能。模型经过此阶段时,需完成指令微调和强化学习两部分任务。在指令微调任务中,模型首先基于前期收集的文本数据,依赖符合中医药理论特点的诊断策略,根据(指令,输出)对构建提示词模板,然后输入到通用语言模型中,自动生成用于模型微调的指令数据,并以此反复采用多轮问答方法优化对话数据质量,从而允许模型在知识储备的基础上进一步学习任务的特定细节。

当前,LoRA[21]算法在中医药领域大语言模型的参数微调任务中越来越受欢迎,这是一种低阶自适应微调的方法,其通过在模型的权重矩阵中引入两个低阶矩阵来近似全参数微调的效果,以此减小下游任务的可训练参数规模。LoRA方法可用于在保证大部分预训练参数不变的情况下,通过调整少量参数来适应新的中医药应用场景,有利于增强模型迁移学习的能力。在利用奖励建模优化模型行为时,首先需通过专家标注的中医药对话数据集设计奖励模型,由专家根据模型输出的质量和相关性提供奖励信号,以评估模型回答与人类意图的一致性。在强化学习阶段,奖励模型的反馈对于微调预训练模型至关重要,能有效提升模型的领域适应性。通过反馈信号,模型不断优化其回答,获得更高的奖励,从而提高响应的准确性与真实性。然而,强化学习微调技术的不稳定性和高成本问题仍需进一步解决。结合深度学习等算法进行迭代训练和参数调优,有助于增强模型在中医场景中的鲁棒性,并提升其处理专业知识的可伸缩性与灵活性,推动中医药领域大语言模型的创新与发展。

1.3.3 模型评测

近年来,医学领域的评估基准主要集中在西医,例如MedMCQA[22]和MultiMedQA[23]被广泛用于医学考试、医学问答等生物医学领域评估任务中。然而,中医与西医在理论基础、诊疗方法和整体观念上存在显著差异,前者强调临床经验,而后者强调证据基础和标准化治疗路径。这些差异不仅凸显了中医在诊断、治疗和教学等方面的独特性,还表明了现有西医评估基准难以全面评测模型的综合性能。因此,根据中医药领域不同应用场景构建多种评估基准,有利于验证和应用大语言模型的能力,有助于提升模型在实际中医辨证诊断场景中的性能。为满足中医药标准化评估基准的迫切需要,许多学者构建了多种评测数据集以评估大语言模型在中医药领域的问答性能,见表 2[24-27]。

表 2 中医药领域大语言模型的典型评测数据集Table 2. Typical evaluation data set of large language model in the field of traditional Chinese medicine数据集 发表年份 数据样式 基本内容 覆盖领域 TCM-QA[24] 2024 单项选择题、多项选择题、是非题 共有801对问题和答案 中医基础、中医诊断、中医治疗 TCM-ED[25] 2024 单项选择题、不定项选择题 来自中医执照考试试题的5 473道测试题,1 300个问题附有权威性分析 中医基础、临床实践 TCMD[26] 2024 多项选择题 共包含3 451个问题记录,其中有2 851个训练集问题和600个测试集问题 中医基础、中医经典、临床实践、西医综合、医学人文等 DigestDS[27] 2024 症状描述和相应的处方信息 包含来自消化系统疾病专家的临床记录,涵盖了患者的症状描述、病史、舌苔信息及处方中草药的名称和剂量 中医药消化系统疾病的处方推荐 Qibo-benchmark[17] 2024 多项选择题 主观评估包括150个与中医药相关的问题,客观评估有3 175个与13种中医药实践考试相关的习题,传统中医自然语言处理任务评估包括517条处方识别数据、689条辨证分析数据和475条阅读理解测验数据 中医书籍、古籍文献、医疗对话 此外,在评估基准的基础上,研究人员还会使用自动评估指标配合人工评估方法,评价大语言模型在中医药领域应用场景中的性能。自动评估一般依赖于预定的标准化指标和工具来评价模型的能力,例如在中医辨证任务中采用准确率、召回率、F1等评价指标,在处方生成任务中可采用BLEU[28]、ROUGE[29]、METEOR[30]等文本生成评价指标。人工评估通过专家向模型提出与中医药知识相关的问题,将模型给出的答案,从知识覆盖范围、答案准确性、错误处理能力、安全性与隐私保护、中医专业术语处理等多方面进行综合评价。综合使用不同评估指标和方法以评价大语言模型在中医药领域的文本处理能力,有助于提升模型处理中医术语的匹配度,有利于提高模型语义分析的一致性。

2. 中医药大语言模型的前沿技术

在中医药领域,文本数据通常表现为结构化程度低、专业术语繁多,以及文化背景丰富,这些特点对传统的自然语言处理模型提出了更高的要求。为了提高处理这类复杂数据的效率和准确性,大语言模型运用了三种前沿理论技术,如提示工程、检索增强生成(RAG)和人类反馈强化学习(RLHF),显著强化了大语言模型在中医药领域的功能,为临床实践提供了有力支持。

2.1 提示工程

提示工程又称上下文提示,通过设计和优化输入提示,引导大语言模型的输出,而无需调整模型参数[31]。通过精心设计的提示模板,提示工程有效提升了模型在辨证诊断、知识问答等中医药复杂任务中的语言理解和生成能力。相比传统的连续学习方法,Wei等[32]提出的思维链(CoT)在复杂推理任务中表现优异,尤其适用于中医古籍的推理分析。该方法通过输入多组中医药问题和样例答案,并附详细推理过程,使模型能够模拟推理路径,从而更准确地产出所需答案。此方法显著提升了大语言模型在处理专业术语和药理作用等复杂中医药数据时的推理能力和准确率。然而,尽管思维链等提示工程技术增强了大语言模型的推理能力,推动智能化中医药服务,但手动构建问题模板的高成本及生成结果仍需人工校正,依然是亟待解决的挑战[33]。

2.2 检索增强生成

RAG结合预训练的参数化和非参数化记忆,优化语言生成任务,大幅提高了医学问答的准确性和可靠性[34]。通过接入外部权威知识库,RAG减少了对模型内部知识的依赖,降低了错误信息和幻觉生成的风险,提升了内容质量和可信度[35]。RAG的核心包括索引、检索、生成三阶段,其中索引通过构建背景知识向量数据库,为知识检索和生成奠定基础[36]。在中医药领域,RAG与大语言模型结合,适用于处理电子病历、临床文本和诊断处方等复杂数据。首先将这些数据转换为向量并存储于向量数据库中,然后将用户查询与检索结果结合,生成增强提示模板,从而提供准确的回答,提升模型灵活性。然而,RAG仍面临检索系统局限、模型内容缺失和幻觉现象等问题,未来需要继续优化性能和扩大测试范围[37]。

2.3 人类反馈强化学习

RLHF是一种用于微调大语言模型的特殊技术,旨在通过优化模型的行为,使其输出与用户的偏好和价值观保持一致[38]。RLHF的核心在于奖励建模,通过用户交互学习奖励函数,并利用强化学习算法来优化这一函数,从而使模型更好地对齐用户需求[39]。在中医药领域,RLHF技术可用于微调大语言模型,帮助其更高效地学习复杂的临床知识,并确保生成内容的真实性、专业性和精确性。这种技术在辨证诊断、药方推荐等方面展现出极大的潜力。例如,TCM-FTP[40]和CHIMED-GPT[41]等模型通过结合RLHF技术,显著提升了模型在中医药领域的应用效果,使其生成的答案更贴合实际临床需求和人类偏好。

尽管RLHF能够提高模型与用户之间的协同效率,减少幻觉现象的发生,但这一过程依赖大量人类反馈以确保学习效果最优。此外,为了在模型策略更新时提供稳定性,RLHF常结合策略优化算法(PPO),通过限制策略更新幅度,进一步提升模型输出的安全性和可靠性[42]。然而,RLHF的应用仍面临一些挑战,包括对人类反馈的高依赖性和资源消耗等问题[43]。未来的技术更新需要在减少主观性依赖和提升资源利用效率方面取得突破,以确保模型不仅能够安全引导患者服药,还能为中医药学习提供准确指导,推动该领域的智能化发展。

综上所述,技术进步将显著促进中医药大语言模型的未来发展及其创新应用。未来,这些模型可以在已有的架构上进行深度优化,更好地适应中医药领域的复杂语言特征和丰富的医学背景。具体而言,可通过整合与中医理论更为契合的多模态融合技术,并融入中医古籍、临床数据、方剂和症状等多维度信息,以此提升模型对中医药知识体系的理解和应用能力。此外,自监督学习[44]和少样本学习技术[45]的应用,将成为模型发展的关键,这有助于减少对大量标注数据的依赖,同时提高模型在少样本情况下的适应性和准确性。与此同时,增强现实(AR)[46]和虚拟现实(VR)[47]技术在中医药大语言模型中的应用开辟了新的可能性,为中医学习、实训和诊疗提供了一个沉浸式的环境。这些技术能通过模拟中医诊所环境和复杂的医疗情况,配合大语言模型提供的实时反馈和指导,极大地提升教育和训练的效果。同时,AR和VR还可以用于向患者直观展示病情和治疗计划,增强患者的理解和满意度,并且能支持远程医疗服务,特别是在偏远地区提供高效的医疗支持。总之,未来的技术进步不仅能够增强中医药的传统实践,还能使之适应现代医疗健康的需求,从而推动整个行业的现代化和国际化发展。这将有助于中医药更好地融入全球健康体系,提高其在国际上的影响力和认可度。

3. 大语言模型在中医药领域的应用挑战

3.1 数据安全和隐私保护

由于训练大语言模型时需要大量的个人健康信息和诊疗记录,并且在模型提供疾病咨询、中医诊疗建议等应用时,存在个人敏感信息泄露的隐患。因此,在数据采集、模型训练、部署、输出和应用等多个重要环节,必须保证信息的分析处理符合医疗数据保护的标准规定,以确保模型输出的内容不会侵犯用户隐私。现阶段,针对大语言模型已经识别出多种安全漏洞,如数据投毒攻击、对抗样本攻击、模型窃取攻击、后门攻击等[48]。为确保大语言模型的对话安全,未来可探索结合安全对齐[49]、推理指导[50]、内容过滤[51]等技术,这不仅能增强模型的内在安全机制,还能有效检测和过滤有害的输入或输出信息,从而提升模型的整体安全性和可靠性[52]。

3.2 算法偏见和伦理问题

大语言模型由于其结构复杂和参数众多,其生成过程的不透明性常导致诸如幻觉生成、错误知识及前后不一致等问题。这些问题不仅降低了用户对系统提供信息准确性的信任度,也对系统的实际应用造成了潜在风险[53]。例如,在训练数据时存在对某些中药或治疗方法的偏见,常出现中药推荐或治疗方法的偏差。此外,中医药的传统治疗方法和理论体系与现代医学诊断形式不一,大语言模型在此领域的应用需严格遵守伦理标准,防止在诊断建议生成过程中出现较大偏差。

3.3 语言模型的可解释性

由于中医术语的复杂性和多样性,加之中医经验的个体性和主观性,语言模型通常难以完全掌握经典理论的深层含义。这种局限性使得医生往往对模型的建议持保留态度,可能导致错过最佳治疗时机,而患者不信赖个性化医疗建议也会减少模型的使用频率[54]。此外,语言模型内部的运作和决策过程不透明进一步加剧人们对其的不信任,致使中医专家和患者受这种“黑箱”特性的影响,无法完全接受模型所生成的知识。为了改善这一状况,未来模型训练时既需收集更多高质量的中医经典书目、电子病历等文本数据,还需引入中医药影像、患者问诊音频等多模态数据,以增强模型对中医知识的理解表达能力。

3.4 数据质量和标注问题

中医药领域中的非结构化和半结构化数据中存在大量病、证、方、药等实体,且书目内容极为丰富和复杂,但数据质量参差不齐。这导致了信息的噪声和冗余,阻碍模型对中医药知识的深入理解和有效抽取。大多数中医药语料标注过于依赖词典匹配和人工标注,这不仅会降低知识的准确性,还增加了时间和成本的消耗。鉴于这些挑战,未来研究亟需加强数据治理。一方面,可以采用建立数据收集处理的标准、专家审核和交叉验证等措施来提高数据质量;另一方面,应借助最先进的自然语言处理技术实现标注速度和准确性的提升。

3.5 评估方法标准化和数据集更新

当前中医药领域大语言模型的评估方法和指标缺乏统一标准,模型评估研究正采用不同的评估基准和指标,导致模型间的性能比较和技术改进变得困难。另外,中医药领域大语言模型的评估数据集构建研究尚在起步阶段,数据集的覆盖领域较为匮乏。不断发展的中医知识和临床实践经验,需要专家给出模型评估的统一标准,需要学者定期更新和维护中医药领域评估数据集,以确保评估数据集的多样性和时效性。

4. 大语言模型在中医药领域的应用前景

当前,大语言模型在中医药领域自然语言处理任务中已展示出色表现,能够快速整合分散的中医药数字资源,实现传统方剂、针灸技术等资源的优化配置和高效利用。为更好地提高中医智能诊断模型的性能,未来可将大语言模型与深度学习、医学图像处理等技术相结合,以“多模态+大模型+多任务”的统一学习方法,为中医辨证诊断、中药处方推荐、中医药知识图谱构建、中医药教学等各种应用场景提供新的思路,进一步地推动中医药智能化研究。

4.1 中医辨证诊断

大语言模型通过整合和分析大量中医古典医籍、中药文献和临床案例等数据,展现了卓越的自然语言处理能力。这些模型不仅能准确理解和生成中医相关的专业术语和表达,还能精准地解析中医症状描述、患者主诉以及医案记录,这为中医辨证诊断提供了有力的文本分析支持。现阶段,大语言模型在中医药领域的应用主要集中在文本语料的处理上,但还需依赖多种模态的“四诊”数据及其辨识结果。基于中医辨证思维,结合自然语言处理与其他先进的人工智能技术,并将其广泛应用于中医“四诊”中,能够达到提供更个性化诊疗服务的目的[55]。Yang等[56]将大语言模型集成到舌象识别模型中,通过总结和重组数据信息构建了具备交互式问答能力的舌诊语言模型。Zhu等[57]针对多模态电子健康记录,利用创新的RAG算法和提示工程等技术,有效提升了大语言模型的语义推理能力,显著提高了模型在临床预测任务中的正确性。由此可见,大语言模型利用和处理多模态数据信息的能力,可以帮助实现更深入的病情分析,从而进一步提升中医辨证诊断的效率和质量。

4.2 中药处方推荐

传统中药处方推荐模型通常利用图神经网络[58]、卷积神经网络[59]、生成对抗网络[60]等深度学习技术,以挖掘和推理药物与症状之间网络关系及中药配伍规律,但存在所需数据样本量过大、运行速度较慢、逻辑难以解释等诸多问题[61]。大语言模型的出现,克服了传统模型无法吸收超大规模文本数据的困难,通过结合预训练、监督微调和人类反馈的强化学习等技术,可以在多轮学习中药方剂专业知识的过程中,有效辅助模型准确理解和应用草药配伍规律。融合大语言模型和神经网络的新型中药处方推荐系统[62-64],为人工智能技术在临床中药的合理应用提供了技术支撑。结合大语言模型与神经网络的中药处方推荐系统,既能获得更丰富的症状和药物的语义嵌入,又能进一步学习中医证候与中药之间的复杂关联,从而生成体现辨证论治的个性化处方。此外,利用中药图像数据训练的大语言模型,能够分析药材形状、颜色、纹理等特征,快速识别药物种类,获取药材的性味归经、功效、用法等药材信息。

4.3 中医药知识图谱构建

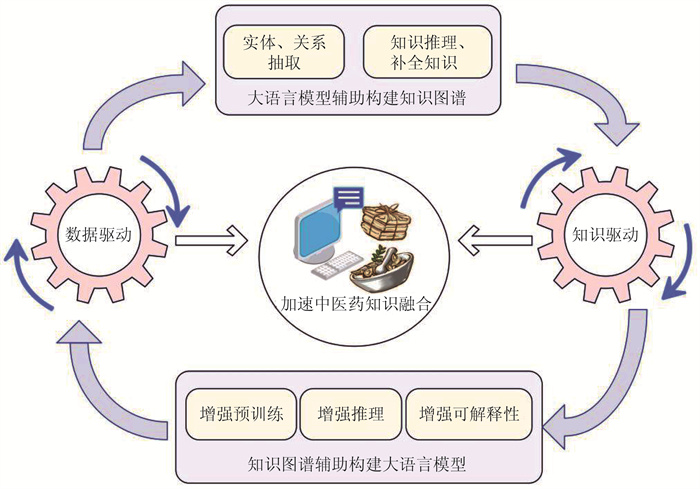

中医药知识图谱构建是中医药智能化研究的重要组成部分,通过知识驱动方法,针对中医药多个应用领域构建本体层,能直观地表现出中医药知识的内部联系。尽管知识图谱在中医药领域取得了一定进展,但仍存在图谱的不完备性和隐性知识未被充分挖掘等问题,阻碍了研究的深入。大语言模型拥有的持续学习能力,及强大的语义理解和内容生成能力,通过数据驱动方法能够有效辅助中医药知识图谱构建。张鹤泽等[65]结合大语言模型与知识图谱构建了中医方剂问答系统,增强了模型信息过滤、专业问答和抽取转化能力,体现了大语言模型和知识图谱在优化中医药智能问答系统过程中的关键作用。因此。将两种技术结合可实现优势互补,共同推动中医药智能化的创新发展。

大语言模型和知识图谱的技术融合框架,见图 3。

大语言模型的对话式提示能力,能辅助中医药文本信息提取和复杂问题推理,进而增强中医药知识图谱在嵌入、补全、构建、问答等方面的效率和准确性。喻金龙等[66]基于ChatGPT的小样本学习能力,针对风湿科中医电子病历进行信息抽取和规范,有效推动了大模型在中医临床文本信息的抽取研究。同时,利用完善好的图谱中实体和关系信息,及对于病、证、方、药等实体的描述,能够有效提高大语言模型学习知识和语言表示的泛化性,有利于减少模型决策能力不足、出现幻觉、黑箱特征等问题。黄勃等[67]提出“图模互补”的概念,在回顾和分析知识图谱增强大语言模型时,介绍了图谱既可为模型提供特定领域预训练语料库,还可有效提高模型在推理、检索、解释知识等方面的性能。此外,将知识图谱和RAG技术相结合,也可提高大语言模型解决中医药领域复杂问题的准确度和可靠性。Nicholas等[68]将知识图谱转换为向量数据库,并基于RAG技术从数据库中检索相关信息,有效支持了生物医学大语言模型输出高质量回复。总而言之,基于数据-知识驱动方法,融合大语言模型与知识图谱两种技术,有利于进一步完备和更新现有中医药知识,极大地促进了中医药知识发现,并为中医药智能化研究提供了新的方向。

4.4 中医药教育

中医药教育对于培养同时具备中医思维和现代医学知识的复合型人才至关重要,需通过系统的教学与研究,以保持中医药理论的连续性和活力,推动中医药现代化进程。大语言模型在中医药教育领域的应用主要表现为:评估检验医学生的专业知识掌握程度[69]、优化教育资源的分配和利用以及辅助教师实现定制化教学[70]。结合中医药基准测试数据集训练大语言模型,能够为中医教学提供更标准的考核系统,有利于减轻教学评测工作的压力,有助于提高中医知识考核的效率和准确性。同时,利用自然语言处理技术,将大语言模型应用于中医药教学中,可以快速从大量中医药文献中提取核心知识,帮助学生更加深入地理解传统中医学理论。此外,多模态大语言模型通过模拟标准化病人与中医师的互动式,可以为学生提供有关“望闻问切”四诊疗法的实践技能培养,有助于促进中医药知识的传承与创新。

5. 总结

随着人工智能技术的不断进步,大语言模型在中医药领域的应用将更加深入和广泛,将为中医药的创新研究和传承提供强有力的支撑,并在中医辨证诊断、中药处方推荐、中医药知识图谱构建、中医药教育等多个应用场景发挥重要作用,为中医药的发展带来创新性的变革。然而,近些年中医药大语言模型在处理错综复杂的医学文本时,容易出现输出偏差知识、患者隐私泄露等伦理风险和技术问题。因此,未来研发中医药大语言模型时需结合自然语言处理与其他人工智能技术,同时融合中医影像数据、患者诊断音频、中医药知识图谱等多模态数据。综合提升模型在更数字化、多样化下游任务场景的迁移能力,从而有效推动中医药的智能化发展。

-

表 1 中医药领域的大语言模型

Table 1 Large language model in the field of traditional Chinese medicine

模型名称 发布时间 基座模型 指令数据 学习范式 独特优势 应用场景 获取途径 TCM-GPT-7B[11] 2023 BLOOM-7B 主要有来源于百度百科和维基百科的20GB的一般语料数据、共6 325个选择题的中医特定检查数据集(TCM-EXAM)和共7 783份中医电子健康记录的数据集(TCM-EHR) 预训练、指令微调 首次在中医药领域对具有7亿参数的大语言模型进行领域适应性验证,并利用基于图的排序算法TextRank和开源的中医词典构建了大规模中医特定语料库TCM-Corpus-1B,显著提升了模型在中医考试和诊断任务中的性能 中医考试和中医诊断 / HuatuoGPT-Ⅱ[12] 2023 Baichuan2 使用了1.1TB的中英文数据,转换成问题-答案对的格式,共2.6万亿个标记 预训练指令微调 将预训练和监督微调统一为一个阶段,并通过数据统一方法将异构数据转换为统一格式,极大增强了模型利用领域知识的能力,使之在中医专业的基准测试中相较于ChatGPT和GPT-4具有独特优势 中医专业测试 https://github.com/Freedom-Intelligence/HuatuoGPT-II ZhongJing中医大模型[13] 2023 LLaMA 包含约70 000个多轮对话和400 000个会话的中国医学多轮问答数据集 预训练、指令微调、人类反馈强化学习 引入了近端策略优化算法引导模型实现与专家医生的意图对齐,显著提升了模型处理复杂对话和主动询问的能力 中医医疗问答 https://github.com/SupritYoung/Zhongjing EpidemicCHAT[14] 2023 ChatGLM 6.9百万条指令数据,包括从194本中医古籍中收集与疫病相关的内容,及中医疫病防治知识图谱 指令微调 扩大了中医药领域大语言模型覆盖的疾病范围,显著提升了模型生成中医疫病防治处方的性能 中医疫病预防和治疗领域的智能问答、症状辅助诊断和中药处方生成 / Lingdan[15] 2024 Baichuan2-13B-Base 共有3个数据集,分别是中医预训练数据集(TCMPT)、中成药问答数据集(TCPM QA)和脾胃草药处方推荐数据集(SSHPR),来源于中医古籍、教材和临床数据等 预训练、指令微调 显著提高了模型在中医临床知识问答和草药处方推荐任务中的性能 中医临床诊断、中药处方推荐 https://github.com/TCMAI-BJTU/LingdanLLM Huang-Di大模型[16] 2024 Ziya-LLaMA-13B-V1 504 372条包含单轮对话和多轮对话的中医古籍指令对话数据及约52k的中文Alpca-GPT-4通用指令微调数据 预训练、指令微调、DPO优化 首个针对中医古籍领域的大语言模型,且结合了自动评估和人工评估两种方法进行模型评估,有效地突破了中医古籍数字化的传统研究模式 中医古籍知识问答 https://github.com/Zlasejd/HuangDI Qibo[17] 2024 LLaMA 主要分为四类指令数据集,包括中医单轮对话数据、中医多轮对话数据、中医自然语言处理任务指令数据和通用医疗相关对话数据 预训练、指令微调 在结合中医知识图谱的同时,通过采用不同粒度的数据处理规则,提升了训练语料的质量,有效增强了模型在中医知识问答方面的泛化性 中医领域知识问答 / CPMI-ChatGLM[18] 2024 ChatGLM-6B 3 906条精心标注的中国专利药物记录 指令微调 首次利用大语言模型对中医专利药物记录进行综合研究,并分别利用LoRA和P-Tuning v2方法进行模型的微调训练 中医药物推荐和用药建议 https://github.com/liucaNN/CPMI-ChatGLM 数智本草 2024 / 1 000种以上古籍及翻译、9万首以上方剂、4 000万份以上文献摘要、2万个以上靶基因通路信息、10万个以上临床方案、16万个以上中药专利及药典政策指南等 预训练、指令微调 “数智本草”语言大模型拥有380亿参数量,有助于帮助学者完成中医药理论证据的挖掘和总结。“数智本草”计算大模型能够更精准地执行计算任务,并结合相应算法快捷实现药材与复方的筛选和优化。 中医智能问答、模型交互计算、中医报告生成 / 天河灵枢[19] 2024 天河天元大模型 中医经典名著、针灸临床循证证据库、中医循证知识图谱等 预训练、指令微调 首个面向中医针灸领域的大语言模型,可提供包括针刺、艾灸、按压等多种针灸治疗方法的个性化建议 中医针灸诊疗问答 / 表 2 中医药领域大语言模型的典型评测数据集

Table 2 Typical evaluation data set of large language model in the field of traditional Chinese medicine

数据集 发表年份 数据样式 基本内容 覆盖领域 TCM-QA[24] 2024 单项选择题、多项选择题、是非题 共有801对问题和答案 中医基础、中医诊断、中医治疗 TCM-ED[25] 2024 单项选择题、不定项选择题 来自中医执照考试试题的5 473道测试题,1 300个问题附有权威性分析 中医基础、临床实践 TCMD[26] 2024 多项选择题 共包含3 451个问题记录,其中有2 851个训练集问题和600个测试集问题 中医基础、中医经典、临床实践、西医综合、医学人文等 DigestDS[27] 2024 症状描述和相应的处方信息 包含来自消化系统疾病专家的临床记录,涵盖了患者的症状描述、病史、舌苔信息及处方中草药的名称和剂量 中医药消化系统疾病的处方推荐 Qibo-benchmark[17] 2024 多项选择题 主观评估包括150个与中医药相关的问题,客观评估有3 175个与13种中医药实践考试相关的习题,传统中医自然语言处理任务评估包括517条处方识别数据、689条辨证分析数据和475条阅读理解测验数据 中医书籍、古籍文献、医疗对话 -

[1] 陈前, 王敏, 任健, 等. 三维重建技术在舌诊中的应用与挑战[J]. 山东中医药大学学报, 2024, 48(3): 375-380. CHEN Q, WANG M, REN J, et al. Application and challenge of three-dimensional reconstruction technology in tongue diagnosis[J]. J Shandong Univ Tradit Chin Med, 2024, 48(3): 375-380.

[2] 殷泽成. 基于对比学习和图网络的中医药处方生成研究[D]. 广州: 广州大学, 2023. YIN Z C. Research on TCM prescription generation based on contrastive learning and graph network[D]. Guangzhou: Guangzhou University, 2023.

[3] DIAO L J, YANG W, ZHU P H, et al. The research of clinical temporal knowledge graph based on deep learning[J]. J Intell Fuzzy Syst, 2021, 41(3): 4265-4274. DOI: 10.3233/JIFS-189687

[4] 宋逸杰, 马素亚, 戴亚盛, 等. 人工智能辅助中医辨证的关键问题与技术挑战[J]. 中国工程科学, 2024, 26(2): 234-244. SONG Y J, MA S Y, DAI Y S, et al. AI-assisted TCM syndrome differentiation: Key issues and technical challenges[J]. Strateg Study CAE, 2024, 26(2): 234-244.

[5] 杨涛, 王欣宇, 朱垚, 等. 大语言模型驱动的中医智能诊疗研究思路与方法[J]. 南京中医药大学学报, 2023, 39(10): 967-971. DOI: 10.14148/j.issn.1672-0482.2023.0967 YANG T, WANG X Y, ZHU Y, et al. Research ideas and methods of intelligent diagnosis and treatment of traditional Chinese medicine driven by large language model[J]. J Nanjing Univ Tradit Chin Med, 2023, 39(10): 967-971. DOI: 10.14148/j.issn.1672-0482.2023.0967

[6] 陈曦. 中国工程院院士张伯礼: 人工智能与中医药结合是必然趋势[N]. 科技日报, 2024-05-17(005). CHEN X. Zhang Boli, Academician of China Academy of Engineering: The combination of artificial intelligence and traditional Chinese medicine is an inevitable trend[N]. Science and Technology Daily, 2024-05-17(005).

[7] MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[EB/OL]. (2013-01-16)[2024-07-10]. https://arxiv.org/abs/1301.3781v3.

[8] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Advances in Neural Information Processing Systems, 2017: 5998-6008.

[9] DEVLIN J, CHANG M W, LEE K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[EB/OL]. (2018-10-11)[2024-07-10]. https://arxiv.org/abs/1810.04805.

[10] RADFORD A, NARASIMHAN K. Improving language understanding by generative pre-training[EB/OL]. (2018-06-11)[2024-07-10]. https://openai.com/index/language-unsupervised/

[11] YANG G X, LIU X H, SHI J Y, et al. TCM-GPT: Efficient pre-training of large language models for domain adaptation in Traditional Chinese Medicine[J]. Comput Meth Programs Biomed Update, 2024, 6: 100158. DOI: 10.1016/j.cmpbup.2024.100158

[12] CHEN J Y, WANG X D, JI K, et al. HuatuoGPT-Ⅱ, one-stage training for medical adaption of LLMs[EB/OL]. (2013-10-16)[2024-07-10]. https://arxiv.org/abs/2311.09774v2.

[13] YANG S H, ZHAO H J, ZHU S B, et al. Zhongjing: Enhancing the Chinese medical capabilities of large language model through expert feedback and real-world multi-turn dialogue[J]. Proc AAAI Conf Artif Intell, 2024, 38(17): 19368-19376.

[14] ZHOU Z Z, YANG T, HU K F. Traditional Chinese medicine epidemic prevention and treatment question-answering model based on LLMs[C]//2023 IEEE International Conference on Bioinformatics and Biomedicine (BIBM), 2023: 4755-4760.

[15] HUA R, DONG X, WEI Y, et al. Lingdan: Enhancing encoding of traditional Chinese medicine knowledge for clinical reasoning tasks with large language models[J]. J Am Med Inform Assoc, 2024, 31(9): 2019-2029. DOI: 10.1093/jamia/ocae087

[16] 张君冬, 杨松桦, 刘江峰, 等. AIGC赋能中医古籍活化: Huang-Di大模型的构建[J]. 图书馆论坛, 2024, 44(10): 103-112. DOI: 10.3969/j.issn.1002-1167.2024.10.011 ZHANG J D, YANG S H, LIU J F, et al. AIGC empowering the revitalization of ancient books on traditional Chinese medicine: Building the Huang-di large language model[J]. Libr Tribune, 2024, 44(10): 103-112. DOI: 10.3969/j.issn.1002-1167.2024.10.011

[17] ZHANG H Y, WANG X, MENG Z P, et al. Qibo: A large language model for traditional Chinese medicine[EB/OL]. (2024-06-22)[2024-07-10]. https://doi.org/10.48550/arXiv.2403.16056.

[18] LIU C, SUN K J, ZHOU Q Q, et al. CPMI-ChatGLM: Parameter-efficient fine-tuning ChatGLM with Chinese patent medicine instructions[J]. Sci Rep, 2024, 14(1): 6403. DOI: 10.1038/s41598-024-56874-w

[19] 潘小丽, 白丽丽, 金舒文, 等. 智能针灸临床决策支持系统研究现状及发展策略[J]. 中华针灸电子杂志, 2024, 13(2): 50-55. PAN X L, BAI L L, JIN S W, et al. Research status and development strategies of intelligent acupuncture clinical decision support system[J]. Chin J Acupunct Moxibustion Electron Ed, 2024, 13(2): 50-55.

[20] 阮彤, 卞俣昂, 余广涯, 等. 医学大语言模型研究与应用综述[J]. 中国卫生信息管理杂志, 2023, 20(6): 853-861. RUAN T, BIAN Y A, YU G Y, et al. A review on research and application of medical large language models[J]. Chin J Health Inform Manag, 2023, 20(6): 853-861.

[21] HU J E, SHEN Y, WALLIS P, et al. LoRA: Low-Rank Adaptation of Large Language Models. [EB/OL]. (2021-06-17)[2024-07-10]. https://arxiv.org/abs/2106.09685.

[22] PAL A, UMAPATHI L K, SANKARASUBBU M. Medmcqa: A large-scale multi-subject multi-choice dataset for medical domain question answering[C]. Conference on health, inference, and learning, 2022.

[23] SINGHAL K, AZIZI S, TU T, et al. Large language models encode clinical knowledge[J]. Nature, 2023, 620(7972): 172-180. DOI: 10.1038/s41586-023-06291-2

[24] LI Y Z, HUANG S H, QI J X, et al. Exploring the comprehension of ChatGPT in traditional Chinese medicine knowledge[EB/OL]. (2024-05-14)[2024-07-10]. https://arxiv.org/abs/2403.09164v1.

[25] YUE W J, WANG X L, ZHU W, et al. TCMBench: A comprehensive benchmark for evaluating large language models in traditional Chinese medicine[EB/OL]. (2024-06-03)[2024-07-10]. https://arxiv.org/abs/2406.01126v1.

[26] YU P, SONG K T, HE F C, et al. TCMD: A traditional Chinese medicine QA dataset for evaluating large language models[EB/OL]. (2024-06-07)[2024-07-10]. https://arxiv.org/abs/2406.04941v1.

[27] ZHOU X Z, DONG X, LI C H, et al. TCM-FTP: Fine-tuning large language models for herbal prescription prediction[EB/OL]. (2024-07-15)[2024-12-01]. https://arxiv.org/abs/2407.10510v1.

[28] PAPINENI K, ROUKOS S, WARD T, et al. BLEU: A method for automatic evaluation of machine translation[J]. Proc Annu Meet Assoc Comput Linguist, 2002, 2002: 311-318.

[29] LIN C Y. Rouge: A package for automatic evaluation of summaries[C]//Text summarization branches out, 2004: 74-81.

[30] BANERJEE S, LAVIE A. METEOR: An automatic metric for mt evaluation with improved correlation with human judgments[J]. Intrinsic Extrinsic Eval Meas Mach Transl And/or Summ Proc Work ACL 2005, 2005: 65-72.

[31] 黄峻, 林飞, 杨静, 等. 生成式AI的大模型提示工程: 方法、现状与展望[J]. 智能科学与技术学报, 2024, 6(2): 115-133. HUANG J, LIN F, YANG J, et al. From prompt engineering to generative artificial intelligence for large models: The state of the art and perspective[J]. Chin J Intell Sci Technol, 2024, 6(2): 115-133.

[32] WEI J, WANG X Z, SCHUURMANS D, et al. Chain-of-thought prompting elicits reasoning in large language models[EB/OL]. (2022-01-28)[2024-07-10]. https://arxiv.org/abs/2201.11903v6.

[33] 李荣涵, 浦荣成, 沈佳楠, 等. 基于思维链的大语言模型知识蒸馏[J]. 数据采集与处理, 2024, 39(3): 547-558. LI R H, PU R C, SHEN J N, et al. Knowledge distillation of large language models based on chain of thought[J]. J Data Acquis Process, 2024, 39(3): 547-558.

[34] LEWIS P, PEREZ E, PIKTUS A, et al. Retrieval-augmented generation for knowledge-intensive nlp tasks[J]. Advances in Neural Information Processing Systems, 2020, 33: 9459-9474.

[35] FAN W, DING Y, NING L, et al. A survey on rag meeting llms: Towards retrieval-augmented large language models[C]//Proceedings of the 30th ACM SIGKDD Conference on Knowledge Discovery and Data Mining, 2024: 6491-6501.

[36] Feng Z, Feng X, Zhao D, et al. Retrieval-generation synergy augmented large language models[C]//ICASSP 2024-2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2024: 11661-11665.

[37] XU S, CHEN M K, CHEN S W. Enhancing retrieval-augmented generation models with knowledge graphs: Innovative practices through a dual-pathway approach[M]//Lecture Notes in Computer Science. Singapore: Springer Nature Singapore, 2024: 398-409.

[38] LIN J Y, MA Z, GOMEZ R, et al. A review on interactive reinforcement learning from human social feedback[J]. IEEE Access, 2020, 8: 120757-120765. DOI: 10.1109/ACCESS.2020.3006254

[39] LEIKE J, KRUEGER D, EVERITT T, et al. Scalable agent alignment via reward modeling: a research direction[EB/OL]. (2018-11-19)[2024-07-10]. https://arxiv.org/abs/1811.07871.

[40] ZHOU X Z, DONG X, LI C H, et al. TCM-FTP: Fine-tuning large language models for herbal prescription prediction[EB/OL]. (2024-07-15)[2024-07-10]. https://arxiv.org/abs/2407.10510v1.

[41] TIAN Y H, GAN R Y, SONG Y, et al. ChiMed-GPT: A Chinese medical large language model with full training regime and better alignment to human preferences[EB/OL]. (2023-11-10)[2024-07-10]. https://arxiv.org/abs/2311.06025v3.

[42] 刘昆麟, 屈新纪, 谭芳, 等. 大语言模型对齐研究综述[J]. 电信科学, 2024, 40(6): 173-194. LIU K L, QU X J, TAN F, et al. Survey on large language models alignment research[J]. Telecommun Sci, 2024, 40(6): 173-194.

[43] LIU Y, YANG Z W, YU Z Y, et al. Generative artificial intelligence and its applications in materials science: Current situation and future perspectives[J]. J Materiomics, 2023, 9(4): 798-816. DOI: 10.1016/j.jmat.2023.05.001

[44] LIU X, ZHANG F J, HOU Z Y, et al. Self-supervised learning: Generative or contrastive[J]. IEEE Trans Knowl Data Eng, 2023, 35(1): 857-876.

[45] KESHARI R, GHOSH S, CHHABRA S, et al. Unravelling small sample size problems in the deep learning world[C]//2020 IEEE Sixth International Conference on Multimedia Big Data (BigMM), 2020: 134-143.

[46] SU M T, CHIANG M L, TSAI C H, et al. An acupoint health care system with real-time acupoint localization and visualization in augmented reality[J]. Multimed Syst, 2023, 29(4): 2217-2238. DOI: 10.1007/s00530-023-01104-y

[47] BAO X L, SONG X, DENG H L, et al. The impact of virtual reality training combined with traditional Chinese medicine health preservation therapy on cognitive function, neurological function, and physical function of stroke patients[J]. Int J Neurosci, 2024: 1-19.

[48] 陶建华, 聂帅, 车飞虎. 语言大模型的演进与启示[J]. 中国科学基金, 2023, 37(5): 767-775. TAO J H, NIE S, CHE F H. The evolution and inspiration of large language model technology[J]. Bull Natl Nat Sci Found China, 2023, 37(5): 767-775.

[49] DAI J, PAN X H, SUN R Y, et al. Safe RLHF: Safe reinforcement learning from human feedback[EB/OL]. (2023-10-19)[2024-07-10]. https://arxiv.org/abs/2310.12773v1.

[50] PHUTE M, HELBLING A, HULL M, et al. LLM self defense: By self examination, LLMs know they are being tricked[EB/OL]. (2023-07-14)[2024-07-10]. https://arxiv.org/abs/2308.07308v4.

[51] ALON G, KAMFONAS M. Detecting language model attacks with perplexity[EB/OL]. (2023-08-27)[2024-07-10]. https://arxiv.org/abs/2308.14132v3.

[52] DONG Z C, ZHOU Z H, YANG C, et al. Attacks, defenses and evaluations for LLM conversation safety: A survey[EB/OL]. (2024-02-14)[2024-07-10]. https://arxiv.org/abs/2402.09283v3.

[53] 车万翔, 窦志成, 冯岩松, 等. 大模型时代的自然语言处理: 挑战、机遇与发展[J]. 中国科学: 信息科学, 2023, 53(9): 1645-1687. CHE W X, DOU Z C, FENG Y S, et al. Towards a comprehensive understanding of the impact of large language models on natural language processing: Challenges, opportunities and future directions[J]. Sci Sin Informationis, 2023, 53(9): 1645-1687.

[54] 颜见智, 何雨鑫, 骆子烨, 等. 生成式大语言模型在医疗领域的潜在典型应用与面临的挑战[J]. 医学信息学杂志, 2023, 44(9): 23-31. YAN J Z, HE Y X, LUO Z Y, et al. Generative large language models in the medical domain: Potential and typical applications and challenges[J]. J Med Inform, 2023, 44(9): 23-31.

[55] 高远, 张仕娜, 盛博洋, 等. 由ChatGPT引发中医智能诊断研究中数据问题的思考[J]. 湖南中医药大学学报, 2023, 43(7): 1320-1324. GAO Y, ZHANG S N, SHENG B Y, et al. Thoughts on data issues in intelligent diagnosis research of TCM prompted by ChatGPT[J]. J Hunan Univ Chin Med, 2023, 43(7): 1320-1324.

[56] YANG Y, YIN Y X, LI Z. Research on the model of automatic recognition and natural language question-answer system for traditional Chinese medicine tongue images based on LLMs[J]. Appl Comput Eng, 2024, 36(1): 271-277. DOI: 10.54254/2755-2721/36/20230461

[57] ZHU Y H, REN C Y, XIE S Y, et al. REALM: RAG-driven enhancement of multimodal electronic health records analysis via large language models[EB/OL]. (2024-02-10)[2024-07-10]. https://arxiv.org/abs/2402.07016v1.

[58] YANG Y, RAO Y L, YU M H, et al. Multi-layer information fusion based on graph convolutional network for knowledge-driven herb recommendation[J]. Neural Netw, 2022, 146: 1-10.

[59] ZHOU W A, YANG K, ZENG J Y, et al. FordNet: Recommending traditional Chinese medicine formula via deep neural network integrating phenotype and molecule[J]. Pharmacol Res, 2021, 173: 105752.

[60] RONG C T, LI X Y, SUN X M, et al. Chinese medicine prescription recommendation using generative adversarial network[J]. IEEE Access, 2022, 10: 12219-12228.

[61] 李连新, 杨璠, 朱兆鑫, 等. 中医人工智能辨证研究现状与发展[J]. 世界科学技术-中医药现代化, 2021, 23(11): 4268-4276. LI L X, YANG F, ZHU Z X, et al. Research status and development of artificial intelligence syndrome differentiation in traditional Chinese medicine[J]. Mod Tradit Chin Med Mater Med World Sci Technol, 2021, 23(11): 4268-4276.

[62] QI J Z, WANG X Y, YANG T. Traditional Chinese medicine prescription recommendation model based on large language models and graph neural networks[C]//2023 IEEE International Conference on Bioinformatics and Biomedicine (BIBM), 2023: 4623-4627.

[63] WANG Z, LI K Q, REN Q Y, et al. Traditional Chinese medicine formula classification using large language models[C]//2023 IEEE International Conference on Bioinformatics and Biomedicine (BIBM), 2023: 4647-4654.

[64] 陈祺焘, 倪璟雯, 徐君, 等. 生成式人工智能GPT-4驱动的中药处方生成研究[J]. 中国药房, 2023, 34(23): 2825-2828. CHEN Q T, NI J W, XU J, et al. Generation of traditional Chinese medicine prescription driven by generative artificial intelligence GPT-4[J]. China Pharm, 2023, 34(23): 2825-2828.

[65] 张鹤译, 王鑫, 韩立帆, 等. 大语言模型融合知识图谱的问答系统研究[J]. 计算机科学与探索, 2023, 17(10): 2377-2388. ZHANG H Y, WANG X, HAN L F, et al. Research on question answering system on joint of knowledge graph and large language models[J]. J Front Comput Sci Technol, 2023, 17(10): 2377-2388.

[66] 喻金龙, 张磊, 许宁, 等. ChatGPT在风湿科中医电子病历症状信息预处理中的应用[J/OL]. 中华中医药学刊. https://link.cnki.net/urlid/21.1546.R.20240619.1504.004. YU J L, ZHANG L, XU N, et al. Application of ChatGPT in symptom information preprocessing of electronic medical record of rheumatology[J/OL]. Chin Arch Tradit Chin Med. https://link.cnki.net/urlid/21.1546.R.20240619.1504.004.

[67] 黄勃, 吴申奥, 王文广, 等. 图模互补: 知识图谱与大模型融合综述[J]. 武汉大学学报(理学版), 2024, 70(4): 397-412. HUANG B, WU S A, WANG W G, et al. KG-LLM-MCom: A survey on integration of knowledge graph and large language model[J]. J Wuhan Univ Nat Sci Ed, 2024, 70(4): 397-412.

[68] MATSUMOTO N, MORAN J, CHOI H, et al. KRAGEN: A knowledge graph-enhanced RAG framework for biomedical problem solving using large language models[J]. Bioinformatics, 2024, 40(6): btae353.

[69] 翟洁, 李艳豪, 李彬彬, 等. 基于大语言模型的个性化实验报告评语自动生成与应用[J]. 计算机工程, 2024, 50(7): 42-52. ZHAI J, LI Y H, LI B B, et al. Personalized experiment report comments auto-generation and application based on large language models[J]. Comput Eng, 2024, 50(7): 42-52.

[70] 谢晖, 朱守平, 刘鹏, 等. 大语言模型+智能评价的"双智"赋能现代工科微生物学混合式课程教学研究与实践[J/OL]. 微生物学通报, 1-14. https://doi.org/10.13344/j.microbiol.china.240301. XIE H, ZHU S P, LIU P, et al. Research and practice on the blended teaching of Modern Engineering Microbiology empowered by large language model and intelligent evaluation[J/OL]. Microbiology China, 1-14. https://doi.org/10.13344/j.microbiol.china.240301.

-

期刊类型引用(5)

1. 姜建明, 乔芬, 刘放. 中医药文化自信的丰富内涵、时代价值及未来展望. 时珍国医国药. 2025(19)  百度学术

百度学术

2. 金哲, 邹健, 李逍, 吕嘉欣, 胡中旭, 冯达. 检索增强生成技术在医学人工智能中的应用与前沿探索. 药物流行病学杂志. 2025(08)  百度学术

百度学术

3. 米未, 李嘉辉, 李曦铭. 中药监管科学的发展现状与对策. 药物评价研究. 2025(06)  百度学术

百度学术

4. 姚兰, 张维纯. 中医智能诊疗系统的研究进展与未来路径. 时珍国医国药. 2025(11)  百度学术

百度学术

5. 王菁,陈炜,冯东. 人工智能大模型对医疗健康行业的影响探析. 现代医院. 2025(05): 759-763 .  百度学术

百度学术

其他类型引用(3)

下载:

下载: